進化するデータセンターのハードウェアや物理設計【特集】

データセンターのハードウェア設計は、今ではかなり標準化が進んだと考えていませんか?

例えばサーバーは、データセンターが存在する前から 19インチラック に設置されています。室内の空気を冷却する技術は高水準なレベルで開発されており、配電も非常に成熟した技術であり、過去数年間を振り返るといくらか増加分の機能拡張のみが行われているように見えます。

【豆知識】1ユニット(U)サイズが44.50mm(1.752in)となり、19インチラックの仕様が現在の形になったのは1992年のEIAによる標準改定によりますが、19インチラック形式は実に遡ること1922年頃にAT&T社により既に標準として確立されていました。

これらを考慮すると、データセンターのハードウェア設計は標準化が進みつつあり、今後は微調整のみに留まるだろうと考える人も多いかもしれません。しかし、それは違います。ラック、冷却、および配電についての抜本的なアプローチは数多く存在します。長年にわたり継続されているものもあれば、突然発生したものもあります。

もちろんそれらすべてが将来牽引力を持つようになるとは限りませんが。では早速見てみましょう。

ラック革命

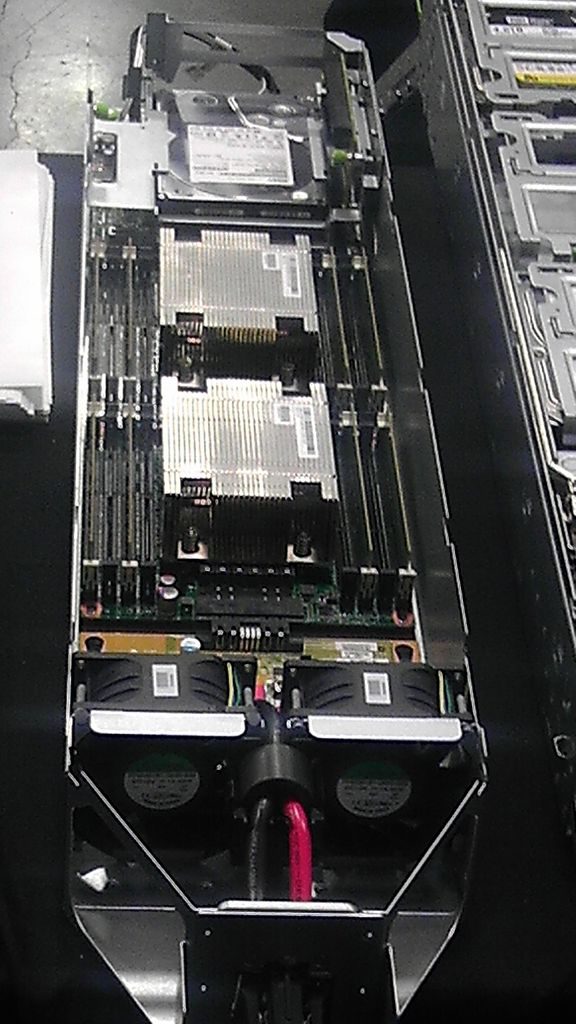

ラックを一般的に列に並べて配置している人がフランスのOVH社の クラウドデータセンター を訪問すると、ある種の混乱を覚えるでしょう。OVHはヨーロッパ地域での主要なクラウドプロバイダーとしてのポジションを目指しています。同社はVMwareと OpenStack ベースのplatform as a service( PaaS ) パブリッククラウド との組み合わせで、企業顧客向けのプライベートクラウドサービスを提供していますが、料金体系は業界の標準とは異なります。そもそもOVHのラックは、垂直ではなく水平配置されています。

フランスのルーベーの施設近くに小さな工場があり、そこでOVHは独自のラックフレームを製造しています。この「ホリラック」と呼ばれるラックは、通常の48Uラックとほぼ同等のサイズではあるが、構成は全く異なります。内部には、3つの小さな16Uラックが横並びで配置されます。この「ホリラック」に工場でサーバーを事前にマウントしてから、主にフランスのOVH施設に向けて出荷されますが、一部は世界の他の場所にも出荷されます。

OVHのチーフインダストリアルオフィサーのFrançois Stérin氏は、水平方式採用の理由は、製造の速さと流通の容易さであると言います。

ラックは、在庫を最小限に抑える”ジャストインタイム”のアプローチで、迅速に製造され、試験が行われます。3人のスタッフが並んで作業し、ハードウェアのロードとテストを行い、フォークリフト、トラック、トレーラー(または船)でラックを目的地のGravelines、Strasbourg、あるいはシンガポールに輸送されます。施設では、最大で3つのラックが積み重ねられ、従来のラックと同じ密度のサーバー実装スペースを提供します。

OVHはPaaSレベルでサービスを販売しているため、その情緒あるハードウェアへの情熱に興じることができます。コロケーションとして顧客のハードウェアを預かることはありません。また、建物自体との融通性を可能にする、冷却に対する新しいアプローチ(後述)を採用しています。

このような変わったアプローチはOVHだけではありません。他にも新しいラックの構成方式を提案している多くの組織があります。最も有名な例としては、Facebookが始めたOpen Compute Project( OCP )やLinkedInが始めた Open19 などのオープンソース・ハードウェアグループなどです。

どちらも「バイヤーズクラブ」として機能し、ハードウェアのカスタムデザインを共有することで、複数の顧客がこれらのカスタマイズ品に対して大量注文のメリットを享受できるようにしています。これは、一般的にキットを簡素化し、最終製品において材料の無駄やエネルギーの無駄を削減することを目的としています。従来のラックやIT機器には、不要な電源機器からメーカーのブランドラベルまで、多くの無駄な材料が含まれています。

OCPは、ラックやその他ハードウェアを標準化されたOEMデザインとして開発し、それを一般に共有する目的で、2011年にFacebookによって立ち上げられました。グループの存在理由は、大規模なWebスケール企業が、サプライヤーに独自のカスタマイズ・ハードウェア設計を要求できることでした。この設計をより広く共有することにより、より小規模な企業も利益を享受することができるようになります。そしてそこから広くデザイン改善の提案も集めることができるようになります。

OCPの創設メンバーは皆、巨大なWebスケール企業に注力していますが、アイデアはコロケーション領域にまで拡大している兆候が見られます。コロケーションプロバイダは施設内のハードウェアを最終的に制御することができないため、OCPが想定する一枚岩のようなデータセンターアーキテクチャは提供できませんが、一部のテナント顧客はこのアイデアを採用しています。またOCPは、施設がOCPラックやOCPハードウェアの利用を歓迎し、サポートを可能とするよう「OCP対応」ガイドラインを発行しています。

OCPは、新たなラック設計を提案しました。これは、従来のラックと同じスペースに、より多くのハードウェアが詰め込まれるようになるデザインです。ラック内のスペースをより多く使用することにより、通常の19インチではなく21インチサイズの機器を使用できるようになります。また、44.5mmの通常のラックユニット(RU)と比較して、48mmの OpenU を備えたより深いキットの実装が可能です。

コメント ( 0 )

トラックバックは利用できません。

この記事へのコメントはありません。